Что такое нейронные сети,

что они могут, и как написать нейронную сеть на Python?

что они могут, и как написать нейронную сеть на Python?

Узнайте о том, как работают нейронные сети, какие задачи они могут решать и напишите свою первую нейронную сеть на Python и Keras

Краткое оглавление

Часть 1. Что такое нейронные сети, и что они могут?

Часть 2. Как написать нейронную сеть на Python?

- Нейронные сети решают интеллектуальные задачи

- Типы задач, которые решают нейронные сети

- Отличия нейронных сетей от классического машинного обучения

- Строение биологического и модель искусственного нейронов

- Типы обучения

- Архитектуры нейронных сетей

- Как нейронная сеть встраивается в Production?

- Библиотеки глубокого обучения, и как мы будем работать

Часть 2. Как написать нейронную сеть на Python?

Что такое нейронные сети,

и что они могут?

и что они могут?

Нейронные сети решают интеллектуальные задачи

Начнем с главного. Основное назначение нейронных сетей - это решение интеллектуальных задач.

Для того, чтобы понять, что является интеллектуальной задачей, а что - нет, давайте рассмотрим пример.

Допустим, вы находитесь на вебинаре. Есть ведущий, есть зрители, и есть некий сервис, который обеспечивает проведение трансляции.

Какую работу производит программное обеспечение вебинарного сервиса?

Оно получает видеопоток с камеры ведущего, по определенным правилам его сжимает, переправляет по сети до каждого из участников, распаковывает поток и отдает его конечному зрителю.

То же самое происходит с презентацией, которую демонстрирует ведущий, с чатом и т.д.

Для того, чтобы понять, что является интеллектуальной задачей, а что - нет, давайте рассмотрим пример.

Допустим, вы находитесь на вебинаре. Есть ведущий, есть зрители, и есть некий сервис, который обеспечивает проведение трансляции.

Какую работу производит программное обеспечение вебинарного сервиса?

Оно получает видеопоток с камеры ведущего, по определенным правилам его сжимает, переправляет по сети до каждого из участников, распаковывает поток и отдает его конечному зрителю.

То же самое происходит с презентацией, которую демонстрирует ведущий, с чатом и т.д.

Функционирование такого программного обеспечения - это полностью детерминированный алгоритм:

Такого рода задачи не являются интеллектуальными.

Какие же задачи призваны решать нейронные сети? Их сила заключена в решении так называемых интеллектуальных задач, задач иного типа, например:

- распознавание лиц

- распознавание стульев в ТЦ (отличить стулья KFC от McDonalds)

- автопилот Tesla и т.д.

Эти задачи называются интеллектуальными, так как в них нет определенных заданных шагов для их решения, нет четко прописанной последовательности действий, а сама нейронная сеть обучается в процессе решения такой задачи.

- получить видеопоток с камеры ведущего

- сжать его

- передать в виде пакетов по определенному протоколу до зрителя

- распаковать обратно в видеопоток

- отобразить его для зрителя

Такого рода задачи не являются интеллектуальными.

Какие же задачи призваны решать нейронные сети? Их сила заключена в решении так называемых интеллектуальных задач, задач иного типа, например:

- распознавание лиц

- распознавание стульев в ТЦ (отличить стулья KFC от McDonalds)

- автопилот Tesla и т.д.

Эти задачи называются интеллектуальными, так как в них нет определенных заданных шагов для их решения, нет четко прописанной последовательности действий, а сама нейронная сеть обучается в процессе решения такой задачи.

Место нейронных сетей в области Data Mining и Machine Learning

Сейчас давайте посмотрим на место нейронных сетей в более обширной области Data Mining. Она не представлена на иллюстрации ниже, т.к. является еще более общим понятием, включающим в себя все остальные составляющие, отраженные на схеме.

Data Mining – это непосредственная работа с данными и их анализ человеком с использованием своих собственных интеллектуальных ресурсов.

Классический пример прикладной программы, использующейся в области Data Mining - это широко распространенный пакет MATLAB.

В случае с Data Mining человек сам, как исследователь, занимается этим вопросом и погружается в него. В качестве примерной аналогии здесь можно вспомнить знаменитый фильм "Игры разума", когда главный герой, весь обложенный данными, сидел, думал и разгадывал некий шифр.

Ещё один пример хорошо показывает нам разницу между Data Mining и Machine Learning (Машинное обучение). В то время, когда многие пытались разгадать коды немецкой шифровальной машины "Enigma" вручную, своей головой, английский математик и криптограф Алан Тьюринг создавал машину, которая сама будет разгадывать этот код.

И машина в итоге победила.

Классический пример прикладной программы, использующейся в области Data Mining - это широко распространенный пакет MATLAB.

В случае с Data Mining человек сам, как исследователь, занимается этим вопросом и погружается в него. В качестве примерной аналогии здесь можно вспомнить знаменитый фильм "Игры разума", когда главный герой, весь обложенный данными, сидел, думал и разгадывал некий шифр.

Ещё один пример хорошо показывает нам разницу между Data Mining и Machine Learning (Машинное обучение). В то время, когда многие пытались разгадать коды немецкой шифровальной машины "Enigma" вручную, своей головой, английский математик и криптограф Алан Тьюринг создавал машину, которая сама будет разгадывать этот код.

И машина в итоге победила.

Machine Learning – это обучение машины для того, чтобы она решала задачи определенного типа без участия человека.

Еще один пример - разработка кредитного скоринга в банке, т.е. создание надежной системы оценки кредитоспособности (кредитных рисков) человека, основанная на численных статистических методах.

Во многих случаях это еще делается вручную, человеческими силами. Т.е. человек анализирует множество данных по тем, кто платит или не платит по кредитам и пытается найти те параметры, которые коррелируют с платежеспособностью заемщика.

Это тоже пример обычного классического Data Mining.

Machine Learning же – это ситуация, когда мы на этот Data Mining запускаем алгоритм, по которому происходит работа с данными. И именно написанный человеком алгоритм уже находит определенные закономерности, которые нам важно знать о неких данных.

При этом, алгоритм, скорее всего, не будет выдавать нам эти закономерности в понятном для нас виде, но при этом он будет обладать необходимой предсказательной силой и сможет дать достаточно точный прогноз по платежеспособности того или иного потенциального заемщика.

Еще один пример - разработка кредитного скоринга в банке, т.е. создание надежной системы оценки кредитоспособности (кредитных рисков) человека, основанная на численных статистических методах.

Во многих случаях это еще делается вручную, человеческими силами. Т.е. человек анализирует множество данных по тем, кто платит или не платит по кредитам и пытается найти те параметры, которые коррелируют с платежеспособностью заемщика.

Это тоже пример обычного классического Data Mining.

Machine Learning же – это ситуация, когда мы на этот Data Mining запускаем алгоритм, по которому происходит работа с данными. И именно написанный человеком алгоритм уже находит определенные закономерности, которые нам важно знать о неких данных.

При этом, алгоритм, скорее всего, не будет выдавать нам эти закономерности в понятном для нас виде, но при этом он будет обладать необходимой предсказательной силой и сможет дать достаточно точный прогноз по платежеспособности того или иного потенциального заемщика.

Два вида Machine Learning

Дальше нам важно понимать, что машинное обучение делится на 2 больших класса:

1. Классическое машинное обучение

Это более старый подход, в котором используются такие методы, как метод наименьших квадратов, метод главных компонент и т.д.

Это математические методы, в которых много математической статистики, теории вероятностей, линейной алгебры, математического анализа и т.д. Это операции с матрицами, разделяющие поверхности и др.

В классическом машинном обучении очень велико участие человека.

Например, как писалось распознавание лиц методом классического машинного обучения?

Писалась специальная программа, которая определяла, где глаз, где ухо, где рот и т.д. Для этого специалист самостоятельно проводил анализ и создавал алгоритм, работающий по заданным параметрам.

Например, рассчитывалось расстояние между глазами, угол наклона глаза по отношению к носу, размер губ, расположение ушей и т.д.

Т.е. человек самостоятельно продумывал алгоритм, выделяя множество параметров и то, как они соотносятся друг с другом, а дальше уже распознавала машина на основе тех "ориентиров", которые ей дал человек.

1. Классическое машинное обучение

Это более старый подход, в котором используются такие методы, как метод наименьших квадратов, метод главных компонент и т.д.

Это математические методы, в которых много математической статистики, теории вероятностей, линейной алгебры, математического анализа и т.д. Это операции с матрицами, разделяющие поверхности и др.

В классическом машинном обучении очень велико участие человека.

Например, как писалось распознавание лиц методом классического машинного обучения?

Писалась специальная программа, которая определяла, где глаз, где ухо, где рот и т.д. Для этого специалист самостоятельно проводил анализ и создавал алгоритм, работающий по заданным параметрам.

Например, рассчитывалось расстояние между глазами, угол наклона глаза по отношению к носу, размер губ, расположение ушей и т.д.

Т.е. человек самостоятельно продумывал алгоритм, выделяя множество параметров и то, как они соотносятся друг с другом, а дальше уже распознавала машина на основе тех "ориентиров", которые ей дал человек.

2. Нейронные сети

Нейронные сети отличаются от классического машинного обучения тем, что они самообучающиеся. В случае с нейронными сетями человек, например, не пишет алгоритм конкретно под распознавание лиц и т.д.

К примеру, если бы мы писали классическим методом отдельно распознавание лиц и отдельно распознавание кошек и собак, то это были бы категорически разные алгоритмы.

В одном случае мы бы замеряли расстояния (и другие параметры) между элементами лица, в то время как для кошек и собак мы бы выделяли лапы, хвосты, размер тела, формы носов, ушей и т.д.

Отличие нейронной сети в том, что у неё есть принцип, по которому она обучается, и нам нужно лишь дать ей выборку для обучения, чтобы она сама научилась.

Главное – выбрать правильную архитектуру сети (допустим, для работы с 2-D изображениями), указать, сколько классов объектов мы должны иметь на выходе и дать правильную обучающую выборку.

Как следствие, нейронная сеть, обученная распознавать лица и нейронная сеть, обученная распознавать кошек и собак, будут практически одинаковыми.

В них будут определенные отличия, но они будут минимальными.

Нейронные сети отличаются от классического машинного обучения тем, что они самообучающиеся. В случае с нейронными сетями человек, например, не пишет алгоритм конкретно под распознавание лиц и т.д.

К примеру, если бы мы писали классическим методом отдельно распознавание лиц и отдельно распознавание кошек и собак, то это были бы категорически разные алгоритмы.

В одном случае мы бы замеряли расстояния (и другие параметры) между элементами лица, в то время как для кошек и собак мы бы выделяли лапы, хвосты, размер тела, формы носов, ушей и т.д.

Отличие нейронной сети в том, что у неё есть принцип, по которому она обучается, и нам нужно лишь дать ей выборку для обучения, чтобы она сама научилась.

Главное – выбрать правильную архитектуру сети (допустим, для работы с 2-D изображениями), указать, сколько классов объектов мы должны иметь на выходе и дать правильную обучающую выборку.

Как следствие, нейронная сеть, обученная распознавать лица и нейронная сеть, обученная распознавать кошек и собак, будут практически одинаковыми.

В них будут определенные отличия, но они будут минимальными.

Глубокое Обучение (Deep Learning)

И, наконец, в нейронных сетях выделяют глубокое обучение (Deep Learning).

Это достаточно модный термин, поэтому важно объяснить его суть, чтобы развеять некую магию, которая нередко вокруг него существует.

Начнем чуть издалека. Когда нейронная сеть маленькая (без скрытых слоев или с минимальным их количеством), она не способна описать сложные явления и решить сколь-нибудь значимые значимые задачи, и в этом отношении её можно назвать "туповатой".

В глубоких же нейронных сетях количество слоев может достигать десятков и даже сотен, и она имеет огромную мощность для обобщения комплексных сложных явлений и процессов.

В последнее время именно глубокое обучение становится все более популярным и востребованным, т.к. появляется все больше и больше данных, а также постоянно растут вычислительные мощности.

Важно отметить, что глубокое обучение нужно не всегда.

Так, например, если для изучения какого-то явления мы берем модель нейронной сети, сложность которой превосходит сложность самого явления, сеть будет переобучаться, т.е. заучивать шумы, признаки, не отражающие суть изучаемого явления.

Иными словами, сложность нейронной сети должна соответствовать сложности изучаемого явления.

Более того, во многих случаях очень простые нейронные сети в пару слоев оказываются даже более точными, чем очень глубокие сети со множеством слоев.

Причины этого могут крыться в недостаточном количестве данных, в чрезмерной сложности сети по отношению к изучаемому явлению и т.д.

В целом же тенденция такова, что нейронные сети все больше вытесняют классическое машинное обучение, а глубокое обучение преобладает над простыми нейронными сетями с небольшим количеством слоев.

Типы задач, которые решают нейронные сети

Сейчас давайте разберем классические типы задач, которые можно целесообразно решать с использованием нейронных сетей.

Сразу можно сказать, что перечисленные ниже типы нельзя считать жестко разграниченными – они могут плавно перетекать друг в друга.

1. Распознавание образов (классификация)

Классификация - типичная и одна из самых распространенных задач, например:

- Распознавание лиц

- Распознавание эмоций

- Классификация типов огурцов на конвейере при сортировке и т.д.

Задача распознавания образов - это ситуация, когда у нас есть некоторое количество классов (от 2 и более) и нейронная сеть должна отнести образ к той или иной категории. Это задача классификации.

Сразу можно сказать, что перечисленные ниже типы нельзя считать жестко разграниченными – они могут плавно перетекать друг в друга.

1. Распознавание образов (классификация)

Классификация - типичная и одна из самых распространенных задач, например:

- Распознавание лиц

- Распознавание эмоций

- Классификация типов огурцов на конвейере при сортировке и т.д.

Задача распознавания образов - это ситуация, когда у нас есть некоторое количество классов (от 2 и более) и нейронная сеть должна отнести образ к той или иной категории. Это задача классификации.

2. Регрессия

Следующий тип задач - это регрессия.

Суть этой задачи - получить на выходе из нейронной сети не класс, а конкретное число, например:

- Определение возраста по фото

- Прогнозирование курса акций

- Оценка стоимости недвижимости

Например, у нас есть данные об объекте недвижимости, такие как: метраж, количество комнат, тип ремонта, развитость инфраструктуры в окрестностях этого объекта, удаленность от метро и т.д.

И нашей задачей является предсказать цену на этот объект, исходя из имеющихся данных. Задачи такого плана - это задачи регрессии, т.к. на выходе мы ожидаем получить стоимость - конкретное число.

Следующий тип задач - это регрессия.

Суть этой задачи - получить на выходе из нейронной сети не класс, а конкретное число, например:

- Определение возраста по фото

- Прогнозирование курса акций

- Оценка стоимости недвижимости

Например, у нас есть данные об объекте недвижимости, такие как: метраж, количество комнат, тип ремонта, развитость инфраструктуры в окрестностях этого объекта, удаленность от метро и т.д.

И нашей задачей является предсказать цену на этот объект, исходя из имеющихся данных. Задачи такого плана - это задачи регрессии, т.к. на выходе мы ожидаем получить стоимость - конкретное число.

3. Прогнозирование временных рядов

Прогнозирование временных рядов - это задача, во многом схожая с регрессией.

Суть её заключается в том, что у нас есть динамический временной ряд значений, и нам нужно понять, какие значения будут идти в нем дальше.

Например, это задачи по предсказанию:

- Курсов акций, нефти, золота, биткойна

- Изменению процессов в котлах (давление, концентрация тех или иных веществ и т.д.)

- Количества трафика на сайте

- Объемов потребления электроэнергии и т.д.

Даже автопилот Tesla отчасти тоже можно отнести к задаче этого типа, ведь видеоряд следует рассматривать как временной ряд из картинок.

Возвращаясь же к примеру с оценкой процессов, происходящих в котлах, задача, по сути, является двойной.

С одной стороны, мы предсказываем временной ряд давления и концентрации тех или иных веществ, а с другой - распознаем по этому временному ряду паттерны, чтобы оценить, критичная ситуация, или нет. И здесь уже идет распознавание образов.

Именно поэтому мы сразу отметили тот факт, что не всегда есть четкая граница между разными типами задач.

Прогнозирование временных рядов - это задача, во многом схожая с регрессией.

Суть её заключается в том, что у нас есть динамический временной ряд значений, и нам нужно понять, какие значения будут идти в нем дальше.

Например, это задачи по предсказанию:

- Курсов акций, нефти, золота, биткойна

- Изменению процессов в котлах (давление, концентрация тех или иных веществ и т.д.)

- Количества трафика на сайте

- Объемов потребления электроэнергии и т.д.

Даже автопилот Tesla отчасти тоже можно отнести к задаче этого типа, ведь видеоряд следует рассматривать как временной ряд из картинок.

Возвращаясь же к примеру с оценкой процессов, происходящих в котлах, задача, по сути, является двойной.

С одной стороны, мы предсказываем временной ряд давления и концентрации тех или иных веществ, а с другой - распознаем по этому временному ряду паттерны, чтобы оценить, критичная ситуация, или нет. И здесь уже идет распознавание образов.

Именно поэтому мы сразу отметили тот факт, что не всегда есть четкая граница между разными типами задач.

4. Кластеризация

Кластеризация - это обучение, когда нет учителя.

В этой ситуации у нас есть много данных и неизвестно, какие из них к какому классу относятся, при этом есть предположение, что там есть некоторое количество классов.

Например, это:

- Выявление классов читателей при email-рассылках

- Выявление классов изображений

Типичная маркетинговая задача - эффективно вести email-рассылку. Допустим, у нас есть миллион email-адресов, и мы ведем некую рассылку.

Разумеется, люди ведут себя совершенно по-разному: кто-то открывает почти все письма, кто-то не открывает почти ничего.

Кто-то постоянно кликает по ссылкам в письмах, а кто-то просто их читает и кликает крайне редко.

Кто-то открывает письма по вечерам в выходные, а кто-то - утром в будние, и так далее.

Задача кластеризации в этом случае - это анализ всего объема данных и выделение нескольких классов подписчиков, обладающих сходными поведенческими паттернами (в рамках, каждого класса, разумеется).

Другая задача этого типа - это, например, выявление классов для изображений. Один из проектов в нашей Лаборатории - это работа с фентези-картинками.

Если передать эти изображения нейронной сети, то, после их анализа, она, к примеру "скажет" нам, что обнаружила 17 различных классов.

Допустим, один класс - это изображение с замками. Другой - это картинки с изображением человека по центру. Третий класс - это когда на картинке дракон, четвертый - это много персонажей на фоне природного ландшафта, происходит какая-нибудь битва, и т.д.

Это примеры типичных задач кластеризации.

Кластеризация - это обучение, когда нет учителя.

В этой ситуации у нас есть много данных и неизвестно, какие из них к какому классу относятся, при этом есть предположение, что там есть некоторое количество классов.

Например, это:

- Выявление классов читателей при email-рассылках

- Выявление классов изображений

Типичная маркетинговая задача - эффективно вести email-рассылку. Допустим, у нас есть миллион email-адресов, и мы ведем некую рассылку.

Разумеется, люди ведут себя совершенно по-разному: кто-то открывает почти все письма, кто-то не открывает почти ничего.

Кто-то постоянно кликает по ссылкам в письмах, а кто-то просто их читает и кликает крайне редко.

Кто-то открывает письма по вечерам в выходные, а кто-то - утром в будние, и так далее.

Задача кластеризации в этом случае - это анализ всего объема данных и выделение нескольких классов подписчиков, обладающих сходными поведенческими паттернами (в рамках, каждого класса, разумеется).

Другая задача этого типа - это, например, выявление классов для изображений. Один из проектов в нашей Лаборатории - это работа с фентези-картинками.

Если передать эти изображения нейронной сети, то, после их анализа, она, к примеру "скажет" нам, что обнаружила 17 различных классов.

Допустим, один класс - это изображение с замками. Другой - это картинки с изображением человека по центру. Третий класс - это когда на картинке дракон, четвертый - это много персонажей на фоне природного ландшафта, происходит какая-нибудь битва, и т.д.

Это примеры типичных задач кластеризации.

5. Генерация

Генеративные сети (GAN) - это самый новый, недавно появившийся тип сетей, который стремительно развивается.

Если говорить кратко, то их задача – машинное творчество. Под машинным творчеством подразумевается генерация любого контента:

- Текстов (стихи, тексты песен, рассказы)

- Изображений (в том числе фотореалистичных)

- Аудио (генерация голоса, музыкальных произведений) и т.д.

Кроме того, в этот список можно добавить и задачи трансформации контента:

- раскрашивание черно-белых фильмов в цветные

- изменение сезона в видеоролике (например, трансформация окружающей среды из зимы в лето) и др.

В случае с "переделкой" сезона изменения затрагивают все важные аспекты. Например, есть видео с регистратора, в котором машина зимой едет по улицам города, вокруг лежит снег, деревья стоят голые, люди в шапках и т.д.

Параллельно с этим роликом идет другой, переделанный в лето. Там уже вместо снега зеленые газоны, деревья с листвой, люди легко одеты и т.д.

Безусловно, есть и некоторые другие типы задач, которые решают нейронные сети, но все основные мы с вами рассмотрели.

Генеративные сети (GAN) - это самый новый, недавно появившийся тип сетей, который стремительно развивается.

Если говорить кратко, то их задача – машинное творчество. Под машинным творчеством подразумевается генерация любого контента:

- Текстов (стихи, тексты песен, рассказы)

- Изображений (в том числе фотореалистичных)

- Аудио (генерация голоса, музыкальных произведений) и т.д.

Кроме того, в этот список можно добавить и задачи трансформации контента:

- раскрашивание черно-белых фильмов в цветные

- изменение сезона в видеоролике (например, трансформация окружающей среды из зимы в лето) и др.

В случае с "переделкой" сезона изменения затрагивают все важные аспекты. Например, есть видео с регистратора, в котором машина зимой едет по улицам города, вокруг лежит снег, деревья стоят голые, люди в шапках и т.д.

Параллельно с этим роликом идет другой, переделанный в лето. Там уже вместо снега зеленые газоны, деревья с листвой, люди легко одеты и т.д.

Безусловно, есть и некоторые другие типы задач, которые решают нейронные сети, но все основные мы с вами рассмотрели.

Отличия нейронных сетей от классического машинного обучения

Теперь, когда мы с вами поговорили про основные задачи, которые могут решать нейронные сети, стоит чуть подробнее остановиться на тех особенностях, которые отличают нейронные сети от классического машинного обучения.

Мы выделим 5 таких отличий:

Мы выделим 5 таких отличий:

1. Самообучение

Косвенно мы уже касались этой момента выше, поэтом сейчас раскроем его чуть больше.

Суть самообучения заключается в том, что мы задаем общий алгоритм, как она будет обучаться, а дальше она сама "понимает", как некое явление или процесс устроены изнутри.

Суть самообучения заключается в том, что нейронной сети для успешной работы нужно дать правильные, подготовленные данные и прописать алгоритм, по которому она будет обучаться.

В качестве иллюстрации для этой особенности можно привести генетический алгоритм, суть которого мы рассмотрим на примере программы с летающими по экрану монитора смайликами.

Одновременно перемещалось 50 смайликов, и они могли замедляться / ускоряться и менять направление своего движения.

В алгоритме мы заложили, что если они вылетают за край экрана или попадают под клик мыши, то "умирают".

После "смерти" тут же создавался новый смайлик, причем на основании того, кто "прожил" дольше всего.

Это была вероятностная функция, которая отдавала приоритет "рождения" новых смайликов тем, кто прожил дольше всех и минимизировала вероятность появления "потомства" у тех, кто быстро улетел за пределы экрана или попался под клик мыши.

Сразу после запуска программы все смайлики начинают летать хаотично и быстро "умирают", улетая за края экрана.

Проходит буквально 1 минута, и они научаются не "умирать", улетая за правый край экрана, но улетают вниз. Еще через минуту они перестают улетать вниз. Через 5 минут они уже вообще не умирают.

Смайлики разбились на несколько групп: кто-то летал вдоль периметра экрана, кто-то топтался в центре, кто-то нарезал восьмерки, и т.д. При этом мышкой мы их еще не кликали.

Теперь мы начали кликать по ним мышкой и, естественно, они тут же умирали, потом что еще не обучались избегать курсора.

Через 5 минут было невозможно поймать ни одного из них. Как только к ним приближался курсор, смайлики делали какой-нибудь кульбит и уходили от клика - поймать их было невозможно.

Самое важное и восхитительное во всем это то, что мы не закладывали в них алгоритм, как не улетать за края экрана и уворачиваться от мышки. И если первый момент реализовать несложно, то со вторым все на порядок сложнее.

Можно было бы потратить примерно неделю времени и создать нечто подобное, но прелесть в том, что мы добились такого же или даже лучшего результата, потратив на программирование пару часов и еще несколько минут на то, чтобы произошло обучение.

Вдобавок к этому, поменяв пару строчек кода, мы могли бы довнести в их алгоритм обучения любую другую функцию. Например, если это происходит на фоне рабочего стола - не залезать на иконки, которые на нем есть.

Или мы хотим, чтобы они не сталкивались друг с другом. Или мы хотим поделить их на 2 группы, раскрашенных в разные цвета и хотим, чтобы они не сталкивались со смайликами другого цвета. И так далее.

И они обучились бы этому за те же самые 5-10 минут по тем же принципам генетических алгоритмов.

Надеюсь, что этот пример показал вам потрясающую силу всего, что связано с искусственным интеллектом и нейронными сетями.

При всем при этом важно иметь компетенцию писать такие генетические алгоритмы и уметь подавать такой сети правильные входные данные.

Так, в рассмотренном выше примере сначала никак не удавалось добиться сколь-нибудь значимого прогресса в обучении смайликов по той причине, что в качестве входных данных им подавалось расстояние до краев экрана и расстояние до курсора мыши.

В результате этого нейронной сети не хватало мощности обучиться на таком типе данных, и прогресса практически не было.

После этого в качестве входных параметров стали передаваться другие значения - единица, деленная на расстояние до края экрана и единица, деленная на расстояние до курсора.

Результат - прекрасное обучение, о котором мы только что говорили. Почему? Потому что когда они подлетали к краю экрана, этот параметр начинал зашкаливать, его изменение происходило очень быстро, и в этой комбинации нейронная сеть смогла выявить важную закономерность и обучиться.

На этом с самообучением всё, двигаемся дальше.

Косвенно мы уже касались этой момента выше, поэтом сейчас раскроем его чуть больше.

Суть самообучения заключается в том, что мы задаем общий алгоритм, как она будет обучаться, а дальше она сама "понимает", как некое явление или процесс устроены изнутри.

Суть самообучения заключается в том, что нейронной сети для успешной работы нужно дать правильные, подготовленные данные и прописать алгоритм, по которому она будет обучаться.

В качестве иллюстрации для этой особенности можно привести генетический алгоритм, суть которого мы рассмотрим на примере программы с летающими по экрану монитора смайликами.

Одновременно перемещалось 50 смайликов, и они могли замедляться / ускоряться и менять направление своего движения.

В алгоритме мы заложили, что если они вылетают за край экрана или попадают под клик мыши, то "умирают".

После "смерти" тут же создавался новый смайлик, причем на основании того, кто "прожил" дольше всего.

Это была вероятностная функция, которая отдавала приоритет "рождения" новых смайликов тем, кто прожил дольше всех и минимизировала вероятность появления "потомства" у тех, кто быстро улетел за пределы экрана или попался под клик мыши.

Сразу после запуска программы все смайлики начинают летать хаотично и быстро "умирают", улетая за края экрана.

Проходит буквально 1 минута, и они научаются не "умирать", улетая за правый край экрана, но улетают вниз. Еще через минуту они перестают улетать вниз. Через 5 минут они уже вообще не умирают.

Смайлики разбились на несколько групп: кто-то летал вдоль периметра экрана, кто-то топтался в центре, кто-то нарезал восьмерки, и т.д. При этом мышкой мы их еще не кликали.

Теперь мы начали кликать по ним мышкой и, естественно, они тут же умирали, потом что еще не обучались избегать курсора.

Через 5 минут было невозможно поймать ни одного из них. Как только к ним приближался курсор, смайлики делали какой-нибудь кульбит и уходили от клика - поймать их было невозможно.

Самое важное и восхитительное во всем это то, что мы не закладывали в них алгоритм, как не улетать за края экрана и уворачиваться от мышки. И если первый момент реализовать несложно, то со вторым все на порядок сложнее.

Можно было бы потратить примерно неделю времени и создать нечто подобное, но прелесть в том, что мы добились такого же или даже лучшего результата, потратив на программирование пару часов и еще несколько минут на то, чтобы произошло обучение.

Вдобавок к этому, поменяв пару строчек кода, мы могли бы довнести в их алгоритм обучения любую другую функцию. Например, если это происходит на фоне рабочего стола - не залезать на иконки, которые на нем есть.

Или мы хотим, чтобы они не сталкивались друг с другом. Или мы хотим поделить их на 2 группы, раскрашенных в разные цвета и хотим, чтобы они не сталкивались со смайликами другого цвета. И так далее.

И они обучились бы этому за те же самые 5-10 минут по тем же принципам генетических алгоритмов.

Надеюсь, что этот пример показал вам потрясающую силу всего, что связано с искусственным интеллектом и нейронными сетями.

При всем при этом важно иметь компетенцию писать такие генетические алгоритмы и уметь подавать такой сети правильные входные данные.

Так, в рассмотренном выше примере сначала никак не удавалось добиться сколь-нибудь значимого прогресса в обучении смайликов по той причине, что в качестве входных данных им подавалось расстояние до краев экрана и расстояние до курсора мыши.

В результате этого нейронной сети не хватало мощности обучиться на таком типе данных, и прогресса практически не было.

После этого в качестве входных параметров стали передаваться другие значения - единица, деленная на расстояние до края экрана и единица, деленная на расстояние до курсора.

Результат - прекрасное обучение, о котором мы только что говорили. Почему? Потому что когда они подлетали к краю экрана, этот параметр начинал зашкаливать, его изменение происходило очень быстро, и в этой комбинации нейронная сеть смогла выявить важную закономерность и обучиться.

На этом с самообучением всё, двигаемся дальше.

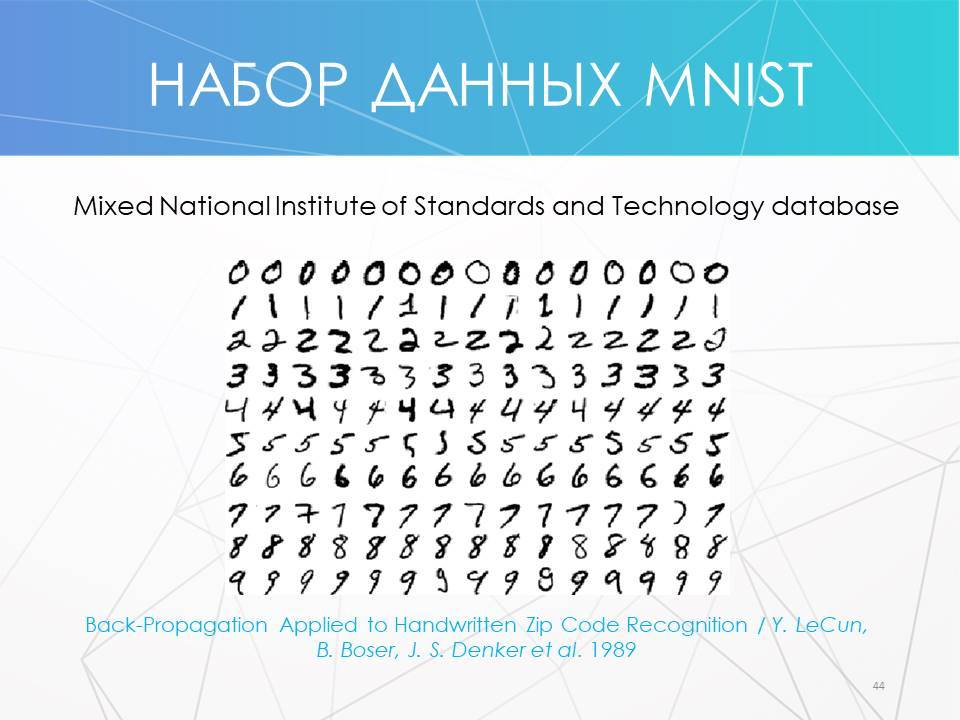

2. Требуется обучающая выборка

Нейронным сетям для обучения требуется обучающая выборка. Это главный минус, т.к. обычно нужно собрать много данных.

К примеру, если мы пишем распознавание лиц в классическом машинном обучении, то нам не нужна база из фотографий – достаточно нескольких фото, по которым человек сам составит алгоритм определения лица, или даже сделает это по памяти, вообще без фото.

В случае с нейронными сетями ситуация иная – нужна большая база того, на чем мы хотим обучить нейронную сеть. При этом важно не только собрать базу, но и определенным образом её предобработать.

Поэтому очень часто сбор базы производится в том числе фрилансерами или крупными бизнесами (классический пример - сбор данных компанией Google для того, чтобы показывать нам капчи).

На своем курсе мы делаем на это упор - в том числе в Лабораториях и во время подготовки дипломных работ. Важно научиться собирать эти данные руками, получив ценный опыт, поняв, как это делается правильно, и на что нужно обратить внимание.

Если вы освоите это сами, то в будущем сможете писать в том числе и правильные ТЗ для подрядчиков, получая качественные, нужные вам результаты.

Нейронным сетям для обучения требуется обучающая выборка. Это главный минус, т.к. обычно нужно собрать много данных.

К примеру, если мы пишем распознавание лиц в классическом машинном обучении, то нам не нужна база из фотографий – достаточно нескольких фото, по которым человек сам составит алгоритм определения лица, или даже сделает это по памяти, вообще без фото.

В случае с нейронными сетями ситуация иная – нужна большая база того, на чем мы хотим обучить нейронную сеть. При этом важно не только собрать базу, но и определенным образом её предобработать.

Поэтому очень часто сбор базы производится в том числе фрилансерами или крупными бизнесами (классический пример - сбор данных компанией Google для того, чтобы показывать нам капчи).

На своем курсе мы делаем на это упор - в том числе в Лабораториях и во время подготовки дипломных работ. Важно научиться собирать эти данные руками, получив ценный опыт, поняв, как это делается правильно, и на что нужно обратить внимание.

Если вы освоите это сами, то в будущем сможете писать в том числе и правильные ТЗ для подрядчиков, получая качественные, нужные вам результаты.

3. Не требуется понимания явления человеком

Третий пункт - это огромный плюс нейронных сетей.

Можно не быть экспертом в какой-либо предметной области, но, будучи экспертом в нейронных сетях решить практически любую задачу.

Да, экспертность, безусловно влияет в плюс, т.к. мы можем лучше предобработать данные и, возможно, быстрее решить задачу, но в целом это не является критическим фактором.

Если в классическом машинном обучении не являясь экспертом в предметной области (например, атомная энергетика, машиностроение, геологические процессы и т.п.) мы вообще не сможем решить задачу, то здесь это вполне реально.

Третий пункт - это огромный плюс нейронных сетей.

Можно не быть экспертом в какой-либо предметной области, но, будучи экспертом в нейронных сетях решить практически любую задачу.

Да, экспертность, безусловно влияет в плюс, т.к. мы можем лучше предобработать данные и, возможно, быстрее решить задачу, но в целом это не является критическим фактором.

Если в классическом машинном обучении не являясь экспертом в предметной области (например, атомная энергетика, машиностроение, геологические процессы и т.п.) мы вообще не сможем решить задачу, то здесь это вполне реально.

4. Значительно точнее в большинстве задач

Следующее значимое преимущество нейронных сетей - их высокая точность.

Например, аварийность автопилотов Tesla на пробег в 1 млн. км. примерно в 10 раз ниже, чем аварийность обычного водителя.

Точность предсказания медицинских диагнозов по МРТ также выше, чем у специалистов-врачей.

Нейронные сети обыгрывают людей практически в любые игры: шахматы, покер, го, компьютерные игры и т.д.

Одним словом, их точность значительно выше практически во всех задачах, что и привело к их все более и более активному использованию в самых разных сферах жизни человека, начиная с маркетинга и финансов, и заканчивая медициной, промышленностью и искусством.

Следующее значимое преимущество нейронных сетей - их высокая точность.

Например, аварийность автопилотов Tesla на пробег в 1 млн. км. примерно в 10 раз ниже, чем аварийность обычного водителя.

Точность предсказания медицинских диагнозов по МРТ также выше, чем у специалистов-врачей.

Нейронные сети обыгрывают людей практически в любые игры: шахматы, покер, го, компьютерные игры и т.д.

Одним словом, их точность значительно выше практически во всех задачах, что и привело к их все более и более активному использованию в самых разных сферах жизни человека, начиная с маркетинга и финансов, и заканчивая медициной, промышленностью и искусством.

5. Непонятно, как работают внутри

Однако, при всех этих возможностях у нейронных сетей есть следующий минус - непонятно, как они работают "внутри".

Мы не можем туда влезть и понять, как там все устроено, как она «мыслит». Это все скрыто в весах, в цифрах.

Более или менее "увидеть" то, что происходит внутри возможно, разве что, в сверточных сетях при работе с изображениями, но даже это не позволяет нам получить полной картины.

Типичный пример того, что нейронная сеть в чем-то похожа на черный ящик - это ситуации, когда, например идет судебный процесс, в ходе которого какие-нибудь компании обращаются в Яндекс и спрашивают, почему именно этот сайт, а не какой-то другой выводится именно на этот позиции в выдаче.

И Яндекс не может ответить на подобные вопросы, т.к. это решение принимается нейронной сетью, а не чётко прописанным алгоритмом, который можно полностью объяснить.

Ответить на такой вопрос - задача столь же нетривиальная, как, например, предсказать точную траекторию, по которой именно с этого стола скатится именно этот металлический шарик, положенный именно в это конкретное место.

Да, законы гравитации нам известны, однако предсказать в точности, как именно будет происходить его движение, практически невозможно.

То же самое с нейронной сетью. Принципы её работы ясны, однако понять, как она сработает в каждом конкретном случае не представляется возможным.

Однако, при всех этих возможностях у нейронных сетей есть следующий минус - непонятно, как они работают "внутри".

Мы не можем туда влезть и понять, как там все устроено, как она «мыслит». Это все скрыто в весах, в цифрах.

Более или менее "увидеть" то, что происходит внутри возможно, разве что, в сверточных сетях при работе с изображениями, но даже это не позволяет нам получить полной картины.

Типичный пример того, что нейронная сеть в чем-то похожа на черный ящик - это ситуации, когда, например идет судебный процесс, в ходе которого какие-нибудь компании обращаются в Яндекс и спрашивают, почему именно этот сайт, а не какой-то другой выводится именно на этот позиции в выдаче.

И Яндекс не может ответить на подобные вопросы, т.к. это решение принимается нейронной сетью, а не чётко прописанным алгоритмом, который можно полностью объяснить.

Ответить на такой вопрос - задача столь же нетривиальная, как, например, предсказать точную траекторию, по которой именно с этого стола скатится именно этот металлический шарик, положенный именно в это конкретное место.

Да, законы гравитации нам известны, однако предсказать в точности, как именно будет происходить его движение, практически невозможно.

То же самое с нейронной сетью. Принципы её работы ясны, однако понять, как она сработает в каждом конкретном случае не представляется возможным.

Строение биологического и модель искусственного нейронов

Строение биологического нейрона

Для того, чтобы понять, как устроен искусственный нейрон, начнем с того, что вспомним, как функционирует обычная нервная клетка.

Именно её строение и функционирование Уоррен Мак-Каллок (американский нейропсихолог, нейрофизиолог, теоретик искусственных нейронных сетей и один из основателей кибернетики) и Уолтер Питтс (американский нейролингвист, логик и математик) взяли как основу для модели искусственного нейрона еще в середине прошлого века.

Итак, как выглядит нейрон?

Для того, чтобы понять, как устроен искусственный нейрон, начнем с того, что вспомним, как функционирует обычная нервная клетка.

Именно её строение и функционирование Уоррен Мак-Каллок (американский нейропсихолог, нейрофизиолог, теоретик искусственных нейронных сетей и один из основателей кибернетики) и Уолтер Питтс (американский нейролингвист, логик и математик) взяли как основу для модели искусственного нейрона еще в середине прошлого века.

Итак, как выглядит нейрон?

У нейрона есть тело, которое накапливает и некоторым образом преобразует сигнал, приходящий к нему через дендриты – короткие отростки, функция которых заключается в приеме сигналов от других нервных клеток.

Накопив сигнал, нейрон передает его по цепочке дальше, другим нейронам, но уже по длинному отростку – аксону, который, в свою очередь, связан с дендритами других нейронов, и так далее.

Конечно, это крайне примитивная модель, т.к. каждый нейрон в нашем мозге может быть связан с тысячами других нейронов.

Следующий момент, на который нам нужно обратить внимание - это то, каким образом сигнал передается от аксона к дендритам следующего нейрона.

Дендриты с аксонами связаны не напрямую, а через так называемые синапсы, и когда сигнал доходит до конца аксона, в синапсе происходит выброс нейромедиатора, определяющего, как именно сигнал будет передан дальше.

Нейромедиаторы - биологически активные химические вещества, посредством которых осуществляется передача электрохимического импульса от нервной клетки через синаптическое пространство между нейронами, а также, например, от нейронов к мышечной ткани или железистым клеткам.

Иными словами, нейромедиатор является неким мостиком между аксоном и множеством дендритов принимающей сигнал клетки.

Если нейромедиатора выбросится много, то сигнал передастся полностью или даже будет усилен. Если же его выбросится мало, то сигнал будет ослаблен, либо вовсе погашен и не передастся другим нейронам.

Таким образом, процесс формирования устойчивых нейронных дорожек (уникальных цепочек связей между нейронами), являющихся биологической основой процесса обучения, зависит от того, сколько будет выброшено нейромедиатора.

Все наше обучение с самого детства построено именно на этом и образование совсем новых связей происходит достаточно редко.

В основном, все наше обучение и освоение новых навыков связано с настройкой того, сколько выбрасывается нейромедиатора в местах контакта аксонов и дендритов.

Например, у нас в нервной системе может быть установлена связь между понятиями "яблоко" и "груша". Т.е. как только мы видим яблоко, слышим слово "яблоко" или просто думаем о нем, в нашем мозгу по механизму ассоциации возникает образ груши, т.к. между этими понятиями у нас установлена связь - сформирована нейронная дорожка.

При этом между понятиями "яблоко" и подушка такой связи, скорее всего нет, поэтому образ яблока не вызывает у нас ассоциаций с подушкой - соответствующая нейронная связь очень слаба или отсутствует.

Интересный момент, о котором также стоит упомянуть, заключается в том, что у насекомых аксон и дендрит связаны напрямую, без выделения нейромедиатора, поэтому у них не происходит обучения в том виде, как оно происходит у животных и человека.

В течение жизни они не обучаются. Они рождаются уже умея всё, что они будут уметь в течение жизни.

Например, каждая конкретная муха не способна научиться облетать стекла - она всегда будет в них биться, что мы с вами постоянно и наблюдаем.

Все нейронные связи у них уже существуют, а сила передачи каждого сигнала уже отрегулирована определенным образом для всех имеющихся связей.

С одной стороны, такая негибкость в плане обучения имеет свои минусы.

С другой стороны, у насекомых, как правило, очень высокая скорость реакции именно за счет другой организации нервных связей, за счет отсутствия веществ-медиаторов, которые, будучи своеобразными посредниками, естественным образом замедляют процесс передачи сигналов.

При всем при этом обучение у насекомых все же может происходить, но только эволюционно - от поколения к поколению.

Допустим, если способность облетать стекла станет важных фактором, способствующим выживанию вида как такового, то за некоторое количество поколений все мухи в мире научатся их облетать.

Пока этого не могло произойти, т.к. сами стекла существую относительно недавно, а для эволюционного обучения могут потребоваться десятки тысяч лет.

Если же это не играет важной роли для сохранения вида, то данная модель поведения так и не будет ими приобретена.

Накопив сигнал, нейрон передает его по цепочке дальше, другим нейронам, но уже по длинному отростку – аксону, который, в свою очередь, связан с дендритами других нейронов, и так далее.

Конечно, это крайне примитивная модель, т.к. каждый нейрон в нашем мозге может быть связан с тысячами других нейронов.

Следующий момент, на который нам нужно обратить внимание - это то, каким образом сигнал передается от аксона к дендритам следующего нейрона.

Дендриты с аксонами связаны не напрямую, а через так называемые синапсы, и когда сигнал доходит до конца аксона, в синапсе происходит выброс нейромедиатора, определяющего, как именно сигнал будет передан дальше.

Нейромедиаторы - биологически активные химические вещества, посредством которых осуществляется передача электрохимического импульса от нервной клетки через синаптическое пространство между нейронами, а также, например, от нейронов к мышечной ткани или железистым клеткам.

Иными словами, нейромедиатор является неким мостиком между аксоном и множеством дендритов принимающей сигнал клетки.

Если нейромедиатора выбросится много, то сигнал передастся полностью или даже будет усилен. Если же его выбросится мало, то сигнал будет ослаблен, либо вовсе погашен и не передастся другим нейронам.

Таким образом, процесс формирования устойчивых нейронных дорожек (уникальных цепочек связей между нейронами), являющихся биологической основой процесса обучения, зависит от того, сколько будет выброшено нейромедиатора.

Все наше обучение с самого детства построено именно на этом и образование совсем новых связей происходит достаточно редко.

В основном, все наше обучение и освоение новых навыков связано с настройкой того, сколько выбрасывается нейромедиатора в местах контакта аксонов и дендритов.

Например, у нас в нервной системе может быть установлена связь между понятиями "яблоко" и "груша". Т.е. как только мы видим яблоко, слышим слово "яблоко" или просто думаем о нем, в нашем мозгу по механизму ассоциации возникает образ груши, т.к. между этими понятиями у нас установлена связь - сформирована нейронная дорожка.

При этом между понятиями "яблоко" и подушка такой связи, скорее всего нет, поэтому образ яблока не вызывает у нас ассоциаций с подушкой - соответствующая нейронная связь очень слаба или отсутствует.

Интересный момент, о котором также стоит упомянуть, заключается в том, что у насекомых аксон и дендрит связаны напрямую, без выделения нейромедиатора, поэтому у них не происходит обучения в том виде, как оно происходит у животных и человека.

В течение жизни они не обучаются. Они рождаются уже умея всё, что они будут уметь в течение жизни.

Например, каждая конкретная муха не способна научиться облетать стекла - она всегда будет в них биться, что мы с вами постоянно и наблюдаем.

Все нейронные связи у них уже существуют, а сила передачи каждого сигнала уже отрегулирована определенным образом для всех имеющихся связей.

С одной стороны, такая негибкость в плане обучения имеет свои минусы.

С другой стороны, у насекомых, как правило, очень высокая скорость реакции именно за счет другой организации нервных связей, за счет отсутствия веществ-медиаторов, которые, будучи своеобразными посредниками, естественным образом замедляют процесс передачи сигналов.

При всем при этом обучение у насекомых все же может происходить, но только эволюционно - от поколения к поколению.

Допустим, если способность облетать стекла станет важных фактором, способствующим выживанию вида как такового, то за некоторое количество поколений все мухи в мире научатся их облетать.

Пока этого не могло произойти, т.к. сами стекла существую относительно недавно, а для эволюционного обучения могут потребоваться десятки тысяч лет.

Если же это не играет важной роли для сохранения вида, то данная модель поведения так и не будет ими приобретена.

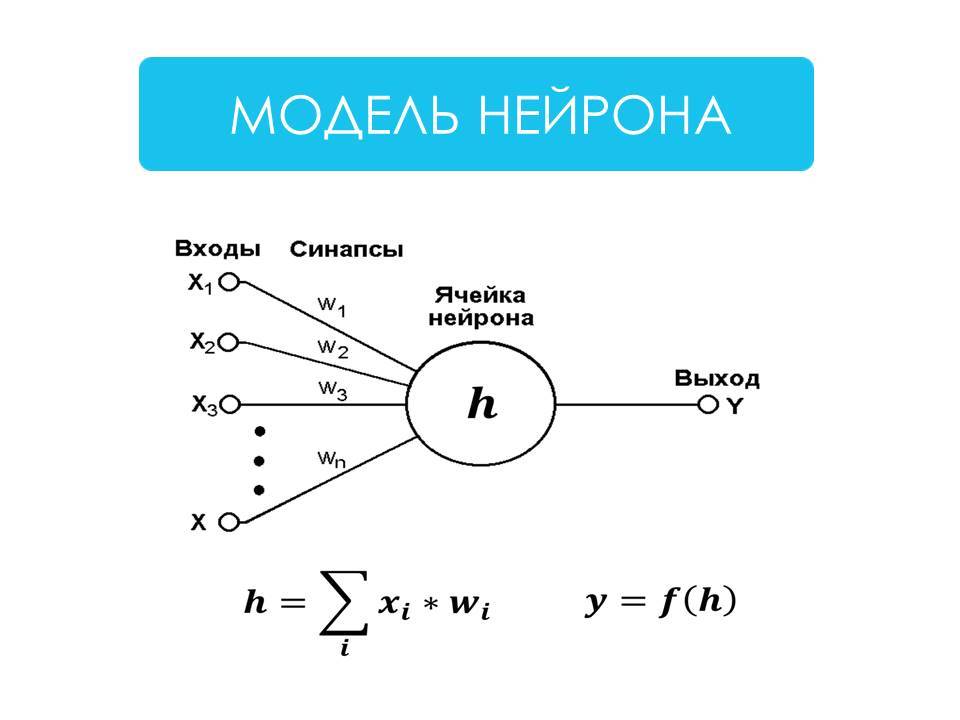

Модель математического нейрона Маккаллока — Питтса

Теперь давайте посмотрим на модель искусственного, математического нейрона Маккаллока - Питтса, разработанную по аналогии с нервными клетками.

Теперь давайте посмотрим на модель искусственного, математического нейрона Маккаллока - Питтса, разработанную по аналогии с нервными клетками.

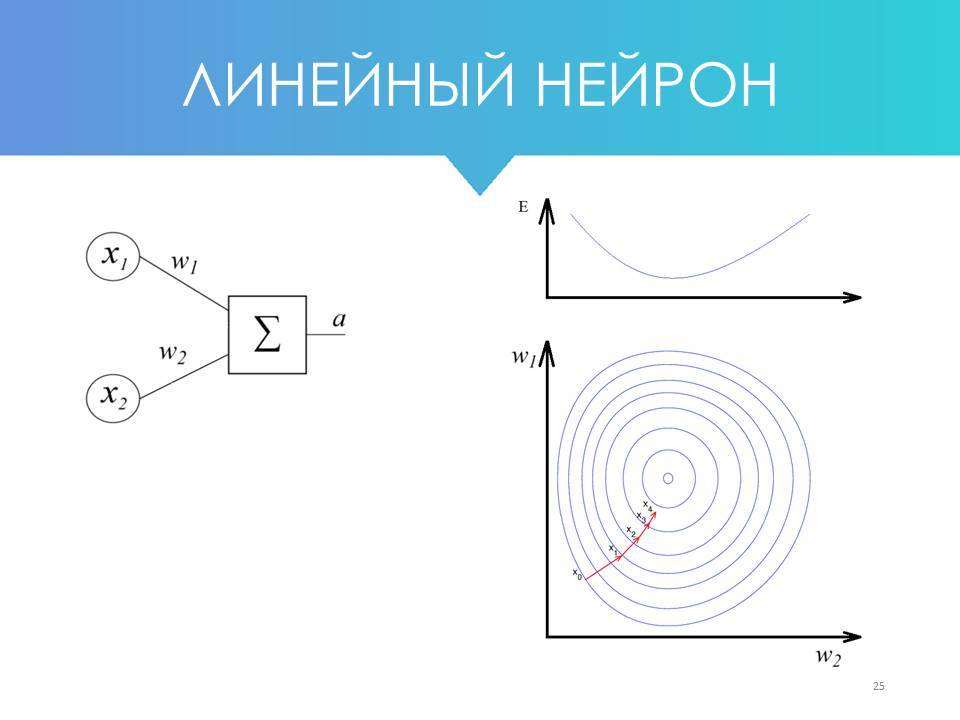

Обычно при работе математическими нейронами используются следующие обозначения:

X – входные данные

W – веса

H – тело нейрона

Y – выход нейронной сети

Входные данные - это сигналы, поступающие к нейрону.

Веса – это эквиваленты синаптической связи и выброса нейромедиатора, представленные в виде чисел, в том числе отрицательных.

Вес представлен действительным числом, на которое будет умножено значение входящего в нейрон сигнала.

Иными словами, вес показывает, насколько сильно между собой связаны те или иные нейроны - это коэффициент связи между ними.

В теле нейрона накапливается взвешенная сумма от перемножения значений входящих сигналов и весов.

Если говорить кратко, то процесс обучения нейронной сети - это процесс изменения весов, т.е. коэффициентов связи между имеющимися в ней нейронами.

В процессе обучения веса меняются, и, если вес положительный, то идет усиление сигнала в нейроне, к которому он приходит.

Если вес нулевой, то влияние одного нейрона на другой отсутствует. Если же вес отрицательный, то идет погашение сигнала в принимающего нейроне.

И, наконец, выход нейронной сети - это то, что мы получаем в результате обработки нейроном поданного на него сигнала. Это некая функция от накопившейся в теле нейрона взвешенной суммы.

X – входные данные

W – веса

H – тело нейрона

Y – выход нейронной сети

Входные данные - это сигналы, поступающие к нейрону.

Веса – это эквиваленты синаптической связи и выброса нейромедиатора, представленные в виде чисел, в том числе отрицательных.

Вес представлен действительным числом, на которое будет умножено значение входящего в нейрон сигнала.

Иными словами, вес показывает, насколько сильно между собой связаны те или иные нейроны - это коэффициент связи между ними.

В теле нейрона накапливается взвешенная сумма от перемножения значений входящих сигналов и весов.

Если говорить кратко, то процесс обучения нейронной сети - это процесс изменения весов, т.е. коэффициентов связи между имеющимися в ней нейронами.

В процессе обучения веса меняются, и, если вес положительный, то идет усиление сигнала в нейроне, к которому он приходит.

Если вес нулевой, то влияние одного нейрона на другой отсутствует. Если же вес отрицательный, то идет погашение сигнала в принимающего нейроне.

И, наконец, выход нейронной сети - это то, что мы получаем в результате обработки нейроном поданного на него сигнала. Это некая функция от накопившейся в теле нейрона взвешенной суммы.

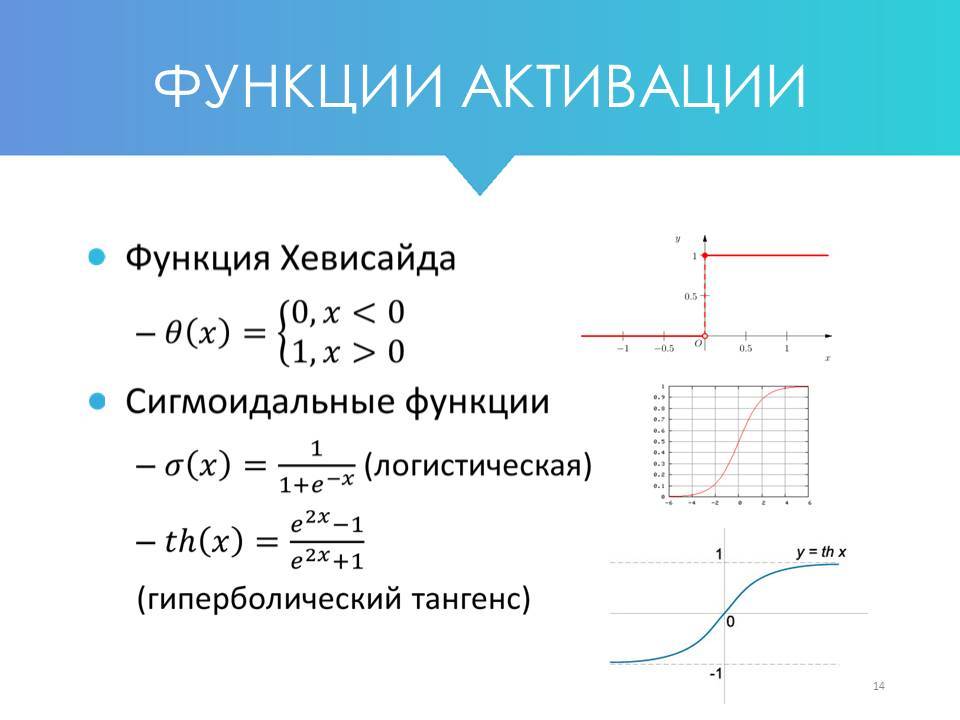

Функции активации

Данную функцию называют функцией активации. Её задача - определить значение выходных данных, выходного сигнала.

Данную функцию называют функцией активации. Её задача - определить значение выходных данных, выходного сигнала.

Эти функции бывают разные, например, если мы имеем дело с функцией Хевисайда, то если в теле нейрона накопилась сумма больше определенного порога, то на выходе будет единица. Если же меньше порога - ноль.

На выходе из нейрона возможны разные значения, однако чаще всего их стараются приводить к диапазону от -1 до 1 или, что бывает еще чаще - от 0 до 1.

Еще один пример - это функция ReLU (на иллюстрации не представлена), которая работает иначе: если значение взвешенной суммы в теле нейрона отрицательно, то идет преобразование в 0, а если положительно, то в X.

Так, если значение на нейроне было -100 то после обработки функцией ReLU оно станет равным 0. Если же это значение равно, например, 15,7, то на выходе будут те же 15,7.

Также для обработки сигнала с тела нейрона применяются сигмоидальные функции (логистическая и гиперболический тангенс) и некоторые другие. Обычно они используются для «сглаживания» значений некоторой величины.

К счастью, для написания кода необязательно понимать различные формулы и графики этих функций, т.к. они уже заложены в библиотеках, используемых для работы с нейронными сетями.

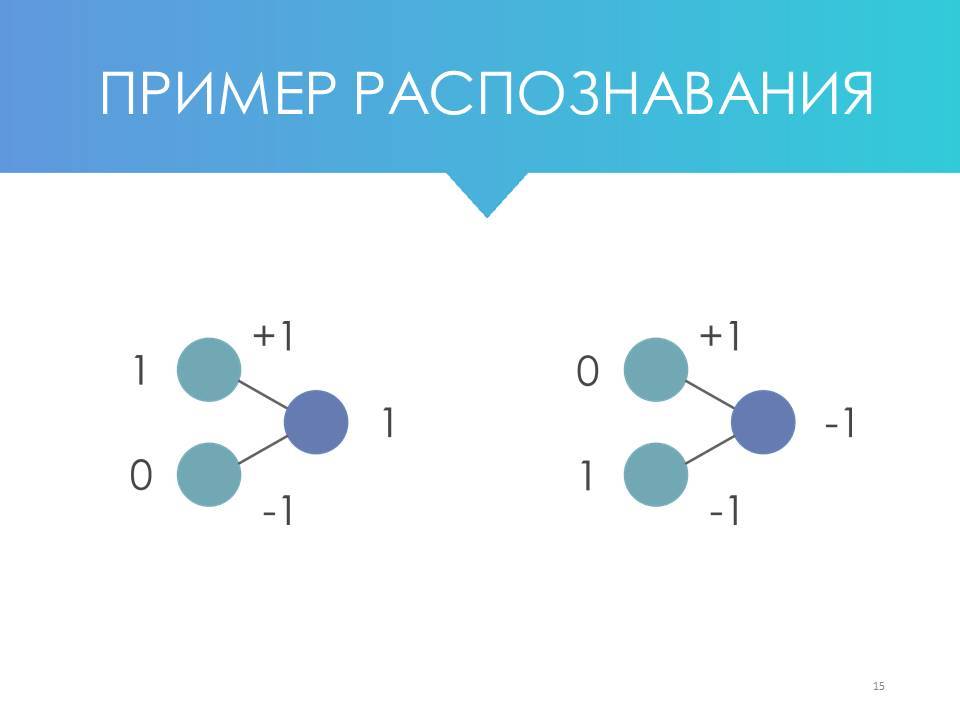

Простейший пример классификации 2 объектов

Теперь, когда мы разобрались с общим принципом работы, давайте посмотрим на простейший пример, иллюстрирующий процесс классификации 2 объектов с помощью нейронной сети.

Представим, что нам нужно отличить входной вектор (1,0) от вектора (0,1). Допустим, черное от белого, или белое от черного.

При этом, в нашем распоряжении есть простейшая сеть из 2 нейронов.

На выходе из нейрона возможны разные значения, однако чаще всего их стараются приводить к диапазону от -1 до 1 или, что бывает еще чаще - от 0 до 1.

Еще один пример - это функция ReLU (на иллюстрации не представлена), которая работает иначе: если значение взвешенной суммы в теле нейрона отрицательно, то идет преобразование в 0, а если положительно, то в X.

Так, если значение на нейроне было -100 то после обработки функцией ReLU оно станет равным 0. Если же это значение равно, например, 15,7, то на выходе будут те же 15,7.

Также для обработки сигнала с тела нейрона применяются сигмоидальные функции (логистическая и гиперболический тангенс) и некоторые другие. Обычно они используются для «сглаживания» значений некоторой величины.

К счастью, для написания кода необязательно понимать различные формулы и графики этих функций, т.к. они уже заложены в библиотеках, используемых для работы с нейронными сетями.

Простейший пример классификации 2 объектов

Теперь, когда мы разобрались с общим принципом работы, давайте посмотрим на простейший пример, иллюстрирующий процесс классификации 2 объектов с помощью нейронной сети.

Представим, что нам нужно отличить входной вектор (1,0) от вектора (0,1). Допустим, черное от белого, или белое от черного.

При этом, в нашем распоряжении есть простейшая сеть из 2 нейронов.

Допустим, что мы зададим верхней связи вес «+1», а нижней – «-1». Теперь, если мы подадим на вход вектор (1,0), то на выходе мы получим 1.

Если же мы подадим на вход вектор (0,1), то на выходе получим уже -1.

Для упрощения примера будем считать, что у нас здесь используется тождественная активационная функция, при которой f(x) равно самому x, т.е. функция никак не преобразует аргумент.

Таким образом, наша нейронная сеть может классифицировать 2 разных объекта. Это совсем-совсем примитивный пример.

Обратите внимание на то, что в данном примере мы сами назначаем веса "+1" и "-1", что не совсем неправильно. В действительности они подбираются автоматически в процессе обучения сети.

Обучение нейронной сети – это подбор весов.

Любая нейронная сеть состоит из 2 составляющих:

Если же мы подадим на вход вектор (0,1), то на выходе получим уже -1.

Для упрощения примера будем считать, что у нас здесь используется тождественная активационная функция, при которой f(x) равно самому x, т.е. функция никак не преобразует аргумент.

Таким образом, наша нейронная сеть может классифицировать 2 разных объекта. Это совсем-совсем примитивный пример.

Обратите внимание на то, что в данном примере мы сами назначаем веса "+1" и "-1", что не совсем неправильно. В действительности они подбираются автоматически в процессе обучения сети.

Обучение нейронной сети – это подбор весов.

Любая нейронная сеть состоит из 2 составляющих:

- Архитектура

- Веса

Архитектура - это её структура и то, как она устроена изнутри (об этом мы поговорим чуть позже).

И когда мы подаем на вход нейронной сети данные, нам нужно её обучить, т.е. подобрать веса между нейронами так, чтобы она действительно выполняла то, что мы от неё ожидаем, допустим, умела отличать фото кошек от фото собак.

На самом деле, обучением нейронной сети можно назвать также и подбор архитектуры в процессе исследования.

Так, например, если мы работаем с генетическими алгоритмами, то в процессе обучения нейронная сеть может менять не только веса, но еще и свою структуру.

Но это скорее исключение, чем правило, поэтому в общем случае под обучением нейронной сети мы будем понимать именно процесс подбора весов.

Типы обучения

Теперь, когда мы поговорили об общем механизме обучения нейронной сети, давайте рассмотрим три типа обучения.

1. С учителем

Обучение с учителем - это одна из самых частых задач. В этом случае у нас есть выборка, и мы знаем по ней правильные ответы.

Мы точно заранее знаем, что на этих 10 тыс. фото - собаки, а на этих 10 тыс. фото - кошки.

Или мы точно знаем курс каких-нибудь акций на протяжении длительного времени.

Допустим, 5 дней до этого дня были такие цены, а на следующий день цена стала такой-то. Затем смещаемся на день вперед, и мы снова знаем: 5 дней цены были такие, а на следующий день цена стала такой-то, и так далее.

Или мы знаем характеристики домов и их реальные цены, если мы говорим про прогнозирование цен на недвижимость.

Все это - примеры обучения с учителем.

Обучение с учителем - это одна из самых частых задач. В этом случае у нас есть выборка, и мы знаем по ней правильные ответы.

Мы точно заранее знаем, что на этих 10 тыс. фото - собаки, а на этих 10 тыс. фото - кошки.

Или мы точно знаем курс каких-нибудь акций на протяжении длительного времени.

Допустим, 5 дней до этого дня были такие цены, а на следующий день цена стала такой-то. Затем смещаемся на день вперед, и мы снова знаем: 5 дней цены были такие, а на следующий день цена стала такой-то, и так далее.

Или мы знаем характеристики домов и их реальные цены, если мы говорим про прогнозирование цен на недвижимость.

Все это - примеры обучения с учителем.

2. Без учителя

Второй тип обучения - это обучение без учителя (кластеризация).

В этом случае мы подаем на вход сети некие данные и предполагаем, что в них можно выделить несколько классов.

Пример: у нас есть большая база email-адресов людей, с которыми мы взаимодействуем.

Они открывают наши письма, читают их, переходят или не переходят по ссылкам. Они делают это в то или иное время суток и т.д.

Обладая этой информацией (например, благодаря статистике почтового рассыльщика), мы можем передать нейронной сети эти данные с "просьбой" выделить несколько классов читателей, которые по тем или иным критериям будут схожи между собой.

Используя эти данные, мы смогли бы выстраивать более эффективную маркетинговую стратегию взаимодействия с каждой из таких групп людей.

Обучение без учителя используется в тех случаях, когда требуется обнаружить внутренние взаимосвязи, зависимости и закономерности, существующие между объектами, но заранее мы не знаем, в чем именно заключаются эти закономерности.

Второй тип обучения - это обучение без учителя (кластеризация).

В этом случае мы подаем на вход сети некие данные и предполагаем, что в них можно выделить несколько классов.

Пример: у нас есть большая база email-адресов людей, с которыми мы взаимодействуем.

Они открывают наши письма, читают их, переходят или не переходят по ссылкам. Они делают это в то или иное время суток и т.д.

Обладая этой информацией (например, благодаря статистике почтового рассыльщика), мы можем передать нейронной сети эти данные с "просьбой" выделить несколько классов читателей, которые по тем или иным критериям будут схожи между собой.

Используя эти данные, мы смогли бы выстраивать более эффективную маркетинговую стратегию взаимодействия с каждой из таких групп людей.

Обучение без учителя используется в тех случаях, когда требуется обнаружить внутренние взаимосвязи, зависимости и закономерности, существующие между объектами, но заранее мы не знаем, в чем именно заключаются эти закономерности.

3. С подкреплением

Третий тип обучения - это обучение с подкреплением. Оно немного похоже на обучение с учителем, когда есть готовая база верных ответов. Отличие заключается в том, что в этом случае у нейронной сети нет всей базы сразу, а дополнительные данные приходят в процессе обучения и дают сети обратную связь о том, достигнута цель или нет.

Простой пример: бот проходит некий лабиринт и на 59 шаге получает информацию о том, что он «упал в яму» или после 100 шагов, выделенных на выход из лабиринта, он узнает, что «не дошел до выхода».

Таким образом нейронная сеть понимает, что последовательность её действий не привела к нужному результату и обучается, корректируя свои действия.

Т.е. заранее сеть не знает, что верно, а что – нет, но получает обратную связь, когда происходит некое событие. По этому принципу строятся практически все игры, а также различные агенты и боты.

Кстати, пример с умирающими смайликами, который мы рассматривали выше - это также обучение с подкреплением.

Кроме того, это автопилоты, подбор стиля под пожелания конкретного человека, исходя из его предыдущих выборов и т.д.

Например, нейронная сеть генерирует 20 картинок и человек выбирает из них 3, которые ему больше всего нравятся. Затем нейронная сеть создает еще 20 картинок и человек снова выбирает то, что ему нравится больше всего и т.д.

Таким образом, сеть выявляет предпочтения человека по стилю изображения, цветовой гамме и другим характеристикам, и может создавать изображения под вкусы каждого конкретного человека.

Третий тип обучения - это обучение с подкреплением. Оно немного похоже на обучение с учителем, когда есть готовая база верных ответов. Отличие заключается в том, что в этом случае у нейронной сети нет всей базы сразу, а дополнительные данные приходят в процессе обучения и дают сети обратную связь о том, достигнута цель или нет.

Простой пример: бот проходит некий лабиринт и на 59 шаге получает информацию о том, что он «упал в яму» или после 100 шагов, выделенных на выход из лабиринта, он узнает, что «не дошел до выхода».

Таким образом нейронная сеть понимает, что последовательность её действий не привела к нужному результату и обучается, корректируя свои действия.

Т.е. заранее сеть не знает, что верно, а что – нет, но получает обратную связь, когда происходит некое событие. По этому принципу строятся практически все игры, а также различные агенты и боты.

Кстати, пример с умирающими смайликами, который мы рассматривали выше - это также обучение с подкреплением.

Кроме того, это автопилоты, подбор стиля под пожелания конкретного человека, исходя из его предыдущих выборов и т.д.

Например, нейронная сеть генерирует 20 картинок и человек выбирает из них 3, которые ему больше всего нравятся. Затем нейронная сеть создает еще 20 картинок и человек снова выбирает то, что ему нравится больше всего и т.д.

Таким образом, сеть выявляет предпочтения человека по стилю изображения, цветовой гамме и другим характеристикам, и может создавать изображения под вкусы каждого конкретного человека.

Архитектуры нейронных сетей

Одной из ключевых задач при создании нейронных сетей является выбор её архитектуры. Он производится разработчиком, исходя из стоящей перед ним задачи и, в общем случае, нейронная сеть обучается только за счет изменения весов.

Исключение – генетические алгоритмы, когда популяция нейронных сетей в процессе обучения самостоятельно пересобирает саму себя и свою архитектуру в том числе.

Однако в подавляющем большинстве случаев в процессе обучения архитектура нейронной сети самопроизвольно не меняется.

Все изменения в нее вносит сам разработчик через добавление или удаление слоев, увеличение или уменьшение количества нейронов на каждом слое и т.д.

Давайте посмотрим на основные архитектуры и начнем с классического примера - полносвязной нейронной сети прямого распространения.

Исключение – генетические алгоритмы, когда популяция нейронных сетей в процессе обучения самостоятельно пересобирает саму себя и свою архитектуру в том числе.

Однако в подавляющем большинстве случаев в процессе обучения архитектура нейронной сети самопроизвольно не меняется.

Все изменения в нее вносит сам разработчик через добавление или удаление слоев, увеличение или уменьшение количества нейронов на каждом слое и т.д.

Давайте посмотрим на основные архитектуры и начнем с классического примера - полносвязной нейронной сети прямого распространения.

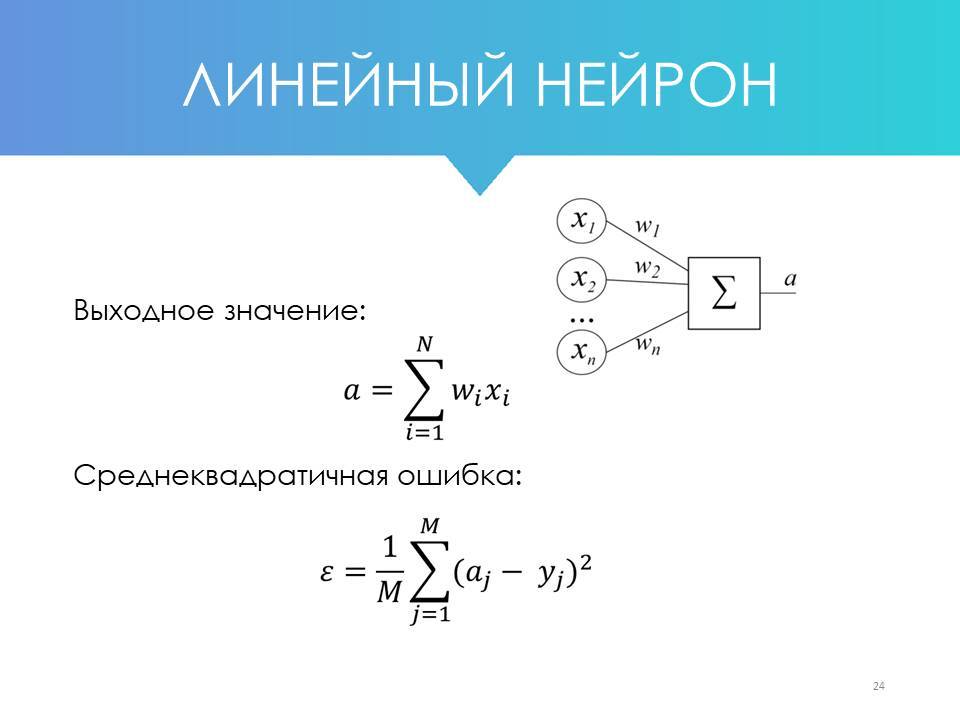

1. Полносвязная нейронная сеть

Полносвязная нейронная сеть прямого распространения - это сеть, в которой каждый нейрон связан со всеми остальными нейронами, находящимися в соседних слоях, и в которой все связи направлены строго от входных нейронов к выходным.

Слева на рисунке мы видим входной слой, на который приходит сигнал. Правее находятся два скрытых слоя, и самый правый слой из двух нейронов – выходной слой.

Эта сеть может решить задачу классификации, если нам нужно выделить два любых класса – допустим, кошек и собак.

Например, верхний из этих двух нейронов отвечает за класс «собаки» и может иметь значения 0 или 1. Нижний – за класс «кошки», и имеет возможность принимать те же самые значения – 0 или 1.

Другой вариант - она может, к примеру, прогнозировать 2 параметра - давление и температуру в котле на основании 3 неких входных данных.

Чтобы лучше понять, как это работает, давайте посмотрим, как такая полносвязная сеть может использоваться, допустим, для прогнозирования погоды.

Слева на рисунке мы видим входной слой, на который приходит сигнал. Правее находятся два скрытых слоя, и самый правый слой из двух нейронов – выходной слой.

Эта сеть может решить задачу классификации, если нам нужно выделить два любых класса – допустим, кошек и собак.

Например, верхний из этих двух нейронов отвечает за класс «собаки» и может иметь значения 0 или 1. Нижний – за класс «кошки», и имеет возможность принимать те же самые значения – 0 или 1.

Другой вариант - она может, к примеру, прогнозировать 2 параметра - давление и температуру в котле на основании 3 неких входных данных.

Чтобы лучше понять, как это работает, давайте посмотрим, как такая полносвязная сеть может использоваться, допустим, для прогнозирования погоды.

В этом примере мы подаем на вход температурные данные по трем последним дням, а на выходе хотим получить предсказания на два следующих дня.

Между входным и выходным слоями у нас есть 2 скрытых слоя, в которых нейронная сеть будет обобщать данные.

Например, в первом скрытом слое один нейрон будет отвечать за такое простое понятие, как «температура растет».

Другой нейрон будет отвечать за понятие «температура падает».

Третий – за понятие «температура неизменна».

Четвертый – «температура очень высокая».

Пятый – «температура высокая».

Шестой – «температура нормальная».

Седьмой – «температура низкая».

Восьмой – «совсем низкая».

Девятый – «температура скакнула вниз и вернулась».

И так далее.

Мы, разумеется, называет все это словами, понятными нам, в то время как сеть сама в процессе обучения сделает так, что каждый из нейронов будет за что-то отвечать, чтобы эффективно обобщать данные.

И каждый из нейронов первого скрытого слоя (в т.ч. обведенный на картинке) будет отвечать за выделение определенного признака в поступивших данных.

Например, если он отвечает за понятие «температура растет», то нейрон с температурой +17 со входного слоя будет входить в него с положительным весом.

Нейрон с температурой +15 – с нулевым весом, а нейрон с температурой +12 – с отрицательным весом.

Если этот так, т.е. температура реально росла и подавались такие данные, обведенный на рисунке нейрон будет активироваться. Если же температура падала, он останется неактивированным.

Нейроны второго скрытого слоя (например, обведенный на картинке ниже), будут отвечать за более высокоуровневые признаки, например, за то, что это осень. Или за то, что это любое другое время года.

Между входным и выходным слоями у нас есть 2 скрытых слоя, в которых нейронная сеть будет обобщать данные.

Например, в первом скрытом слое один нейрон будет отвечать за такое простое понятие, как «температура растет».

Другой нейрон будет отвечать за понятие «температура падает».

Третий – за понятие «температура неизменна».

Четвертый – «температура очень высокая».

Пятый – «температура высокая».

Шестой – «температура нормальная».

Седьмой – «температура низкая».

Восьмой – «совсем низкая».

Девятый – «температура скакнула вниз и вернулась».

И так далее.

Мы, разумеется, называет все это словами, понятными нам, в то время как сеть сама в процессе обучения сделает так, что каждый из нейронов будет за что-то отвечать, чтобы эффективно обобщать данные.

И каждый из нейронов первого скрытого слоя (в т.ч. обведенный на картинке) будет отвечать за выделение определенного признака в поступивших данных.

Например, если он отвечает за понятие «температура растет», то нейрон с температурой +17 со входного слоя будет входить в него с положительным весом.

Нейрон с температурой +15 – с нулевым весом, а нейрон с температурой +12 – с отрицательным весом.

Если этот так, т.е. температура реально росла и подавались такие данные, обведенный на рисунке нейрон будет активироваться. Если же температура падала, он останется неактивированным.

Нейроны второго скрытого слоя (например, обведенный на картинке ниже), будут отвечать за более высокоуровневые признаки, например, за то, что это осень. Или за то, что это любое другое время года.

На активацию данного нейрона будет положительно влиять падение температуры, свойственное осени.

Если наблюдается постепенный рост температуры, то, скорее всего, это статистически будет влиять в минус, т.е. не будет активировать данный нейрон.

Понятно, что бывают ситуации, когда осенью температура растет, но, скорее всего, статистически рост температуры в течение 3 дней будет отрицательно влиять на этот нейрон.

То, что температура слишком высокая, точно будет отрицательно влиять на нейрон, отвечающий за осень, т.к. не бывает очень высоких температур в это время года, и так далее.

И, наконец, нейроны 2 скрытого слоя соединяются с двумя выходными нейронами, которые выдают предсказание по температуре.

При этом обратите внимание, что сами мы не задаем, за что будет отвечать каждый из нейронов (это было бы примером классического машинного обучения). Нейронная сеть сама сделает нейроны "ответственными" за те или иные понятия.

Более того, в рамках нейронной сети привычные нам понятия, такие как "весна", "осень", "температура падает" и т.д. не существуют. Мы просто обозначили их так для своего удобства, чтобы нам было понятнее, что примерно происходит внутри во время обучения.

В действительности же нейронная сеть сама в процессе обучения выделит именно те свойства, которые нужны для решения данной конкретной задачи.

Важно понимать, что нейронная сеть именно с такой архитектурой не будет правильно прогнозировать температуру – это упрощенный пример, показывающий, как внутри сети может происходить выделение различных признаков (так называемый процесс feature extraction).

Процесс выделения признаков хорошо иллюстрирует работа свёрточных нейронных сетей.

Допустим, на вход сети мы подаем фото кошек и собак, и сеть начинает их анализировать.

На первых слоях сеть определяет наиболее общие признаки: линия, круг, темное пятно, угол, близкий к прямому, яркое пятно на фоне темного и т.д.

На следующем слое сеть сможет извлечь уже иные признаки: ухо, лапа, голова, нос, хвост и т.д.

Еще дальше, на следующем слое будет идет анализ уже такого плана:

- здесь хвост загнут вверх, это коррелирует с лайкой, значит собака;

- а тут короткие лапы, а у кошек нет коротких лап, поэтому, скорее всего, собака, такса;

- а вот здесь треугольное ухо с белым кончиком, похоже на такую-то породу кошки, и т.д.

Примерно таким образом происходит процесс feature extraction.

Безусловно, чем больше нейронов в сети, тем более детальные, специфические свойства она может выделить.

Если же нейронов немного, она сможет работать только «крупными мазками», т.к. у нее не хватит мощности проанализировать все возможные комбинации признаков.

Таким образом, общий принцип выделения свойств - это все большее обобщение при переходе с одного слоя на другой, от низкого уровня ко все более высокому.

Итак, давайте снова вспомним, что из себя представляет нейронная сеть.

Во-первых, это архитектура.

Она задается разработчиком, т.е. мы сами определяем, сколько у сети слоев, как они связаны, сколько нейронов на каждом слое, есть ли у этой сети память (об этом чуть позже), какие у нее активационные функции и т.д.

Архитектуру сети можно представить, например, как обычный JSON, YAML или XML-файл (текстовые файлы, в которых можно полностью отразить её структуру).

Во-вторых, это обученные веса.

Веса нейронной сети хранятся в совокупности матриц в виде действительных чисел, количество которых (чисел) равно общему количеству связей между нейронами в самой сети.

Количество самих матриц зависит от количества слоев и того, как нейроны разных слоев связаны друг с другом.

Веса задаются в начале обучения (обычно случайным образом) и подбираются в процессе обучения.

Таким образом, сеть можно легко сохранить через сохранение её архитектуры и весов, а в дальнейшем снова использовать её, обратившись к файлам с архитектурой и весами.

Если наблюдается постепенный рост температуры, то, скорее всего, это статистически будет влиять в минус, т.е. не будет активировать данный нейрон.

Понятно, что бывают ситуации, когда осенью температура растет, но, скорее всего, статистически рост температуры в течение 3 дней будет отрицательно влиять на этот нейрон.

То, что температура слишком высокая, точно будет отрицательно влиять на нейрон, отвечающий за осень, т.к. не бывает очень высоких температур в это время года, и так далее.

И, наконец, нейроны 2 скрытого слоя соединяются с двумя выходными нейронами, которые выдают предсказание по температуре.

При этом обратите внимание, что сами мы не задаем, за что будет отвечать каждый из нейронов (это было бы примером классического машинного обучения). Нейронная сеть сама сделает нейроны "ответственными" за те или иные понятия.

Более того, в рамках нейронной сети привычные нам понятия, такие как "весна", "осень", "температура падает" и т.д. не существуют. Мы просто обозначили их так для своего удобства, чтобы нам было понятнее, что примерно происходит внутри во время обучения.

В действительности же нейронная сеть сама в процессе обучения выделит именно те свойства, которые нужны для решения данной конкретной задачи.

Важно понимать, что нейронная сеть именно с такой архитектурой не будет правильно прогнозировать температуру – это упрощенный пример, показывающий, как внутри сети может происходить выделение различных признаков (так называемый процесс feature extraction).

Процесс выделения признаков хорошо иллюстрирует работа свёрточных нейронных сетей.

Допустим, на вход сети мы подаем фото кошек и собак, и сеть начинает их анализировать.

На первых слоях сеть определяет наиболее общие признаки: линия, круг, темное пятно, угол, близкий к прямому, яркое пятно на фоне темного и т.д.

На следующем слое сеть сможет извлечь уже иные признаки: ухо, лапа, голова, нос, хвост и т.д.

Еще дальше, на следующем слое будет идет анализ уже такого плана:

- здесь хвост загнут вверх, это коррелирует с лайкой, значит собака;

- а тут короткие лапы, а у кошек нет коротких лап, поэтому, скорее всего, собака, такса;

- а вот здесь треугольное ухо с белым кончиком, похоже на такую-то породу кошки, и т.д.

Примерно таким образом происходит процесс feature extraction.

Безусловно, чем больше нейронов в сети, тем более детальные, специфические свойства она может выделить.

Если же нейронов немного, она сможет работать только «крупными мазками», т.к. у нее не хватит мощности проанализировать все возможные комбинации признаков.

Таким образом, общий принцип выделения свойств - это все большее обобщение при переходе с одного слоя на другой, от низкого уровня ко все более высокому.

Итак, давайте снова вспомним, что из себя представляет нейронная сеть.

Во-первых, это архитектура.

Она задается разработчиком, т.е. мы сами определяем, сколько у сети слоев, как они связаны, сколько нейронов на каждом слое, есть ли у этой сети память (об этом чуть позже), какие у нее активационные функции и т.д.

Архитектуру сети можно представить, например, как обычный JSON, YAML или XML-файл (текстовые файлы, в которых можно полностью отразить её структуру).

Во-вторых, это обученные веса.

Веса нейронной сети хранятся в совокупности матриц в виде действительных чисел, количество которых (чисел) равно общему количеству связей между нейронами в самой сети.

Количество самих матриц зависит от количества слоев и того, как нейроны разных слоев связаны друг с другом.

Веса задаются в начале обучения (обычно случайным образом) и подбираются в процессе обучения.

Таким образом, сеть можно легко сохранить через сохранение её архитектуры и весов, а в дальнейшем снова использовать её, обратившись к файлам с архитектурой и весами.